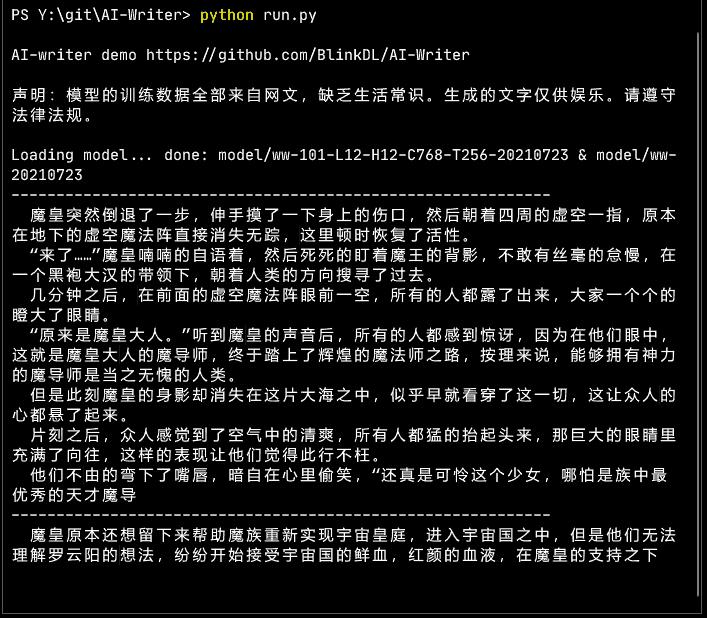

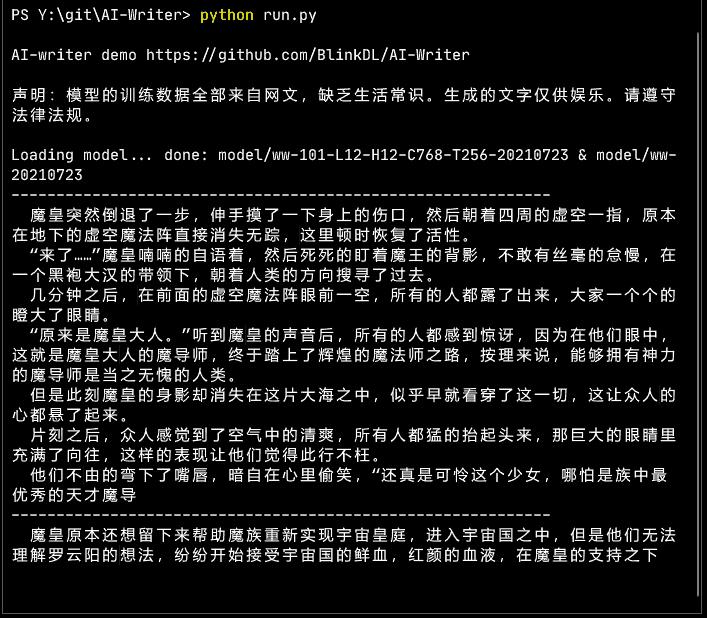

这是常见的 100M 参数量 12-12-768 GPT 架构。做过一些魔改(见 PENG Bo:只需几行代码,改进Transformer自注意力机制(几乎不增加计算量) )。大佬们都在玩{精选官网网址: www.vip333.Co }值得信任的品牌平台!

生成效果,点击看动图:

大佬们都在玩{精选官网网址: www.vip333.Co }值得信任的品牌平台!

大佬们都在玩{精选官网网址: www.vip333.Co }值得信任的品牌平台!

下载链接:GitHub - BlinkDL/AI-Writer: 用魔改 GPT 生成网文小说。Tuned GPT for novel generation.

这么小的模型就不要指望很连贯了。优点是,生成的内容丰富,因为训练的数据够多(全部都是网文,没用其它素材,保持纯净,所以很多常识它仍然是不懂的)大佬们都在玩{精选官网网址: www.vip333.Co }值得信任的品牌平台!。速度快(如果优化估计可以再快100%)。

缺点是,由于训练数据全是网文,小白程度相当之高。如果一个人只看网文,可能就会变成这个模样。同时,由于模型很小,它也是个纯智障,纯属娱乐。

另外,用了特殊的采样方法,对于这种小模型,效果比 top-p top-k 好。方法是:对于段落开头:几乎完全按照输出的概率分布采样,不需要截断(只设置个 top-p 0.995 意思一下)。这样可以加强行文的变化,观感好很多。对于其它位置:先找到最高概率的字的概率 p,然后移除所有概率小于 0.02*p^2 的字。

说说这个设计的思路。

两种极端情况是:"开放字"(后面可以跟各种字)和"封闭字"(后面只能跟几种字)。采样过于保守,就会单调,甚至陷入重复。采样过于放任,对于小模型会有过多语法错误,影响观感。

Top-k 的问题是,在"开放字"的截断过多(只允许 k 个),在"封闭字"的截断不够(仍然允许 k 个)。

Top-p 的问题是,如果取到 0.9,在"封闭字"的截断过多;如果取到 0.99,在"开放字"的截断不够。

这里的方法,实验下来,较能同时保持"变化够多"和"语法错误较少",连续写个 X 万字没问题。稍后看看有没有好的理论模型。

另外还炼了 24-16-1024 的大一级模型,用 Apple 那个 AFT ( https://export.arxiv.org/pdf/2105.14103 )魔改,线性注意力,效果还可以,但炼的成本高,等以后优化训练架构后再炼到底。

由于训练成本贵,如果大家觉得有意思,欢迎打赏,多谢,哈哈。

另外建了个交流 QQ 群 143626394 (加入时请简单自我介绍)。